Du hast dich schon immer gefragt, warum wir eigentlich statistische Tests rechnen und welche Bedeutung p-Werte und Effektstärken haben? Alle diese Fragen beantworten wir dir in dieser Artikelreihe.

Du hast dich schon immer gefragt, warum wir eigentlich statistische Tests rechnen und welche Bedeutung p-Werte und Effektstärken haben? Alle diese Fragen beantworten wir dir in dieser Artikelreihe.

Die wichtigste Unterscheidung, die man bei statistischen Tests immer im Hinterkopf haben sollte, ist die zwischen Population und Stichprobe.

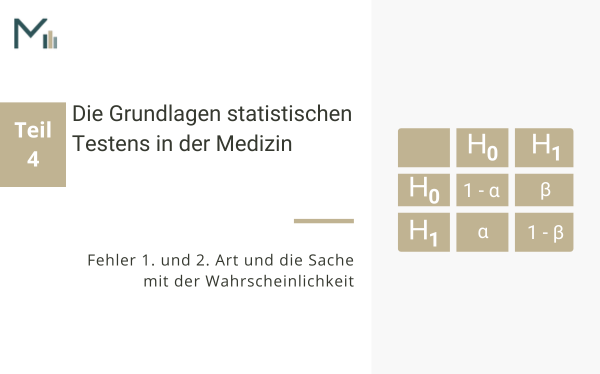

Bei allen statistischen Tests gibt es immer eine Nullhypothese (kurz: H0) und eine Alternativhypothese (kurz: H1).

Ein statistischer Test erlaubt es dir stattdessen, dich aufgrund von Wahrscheinlichkeitsüberlegungen für oder gegen die H1 zu entscheiden.

Was passiert nun genau bei einem statistischen Test und wie soll einem das Ergebnis helfen, eine Entscheidung zwischen H0 und H1 zu treffen?

Eine der unschönen Eigenschaften statistischer Tests (auf die man auch beim Lesen von Forschungsberichten immer achten sollte) ist, dass der p-Wert wesentlich von der Stichprobengröße abhängt.

Wenn du die Ergebnisse deiner Studie beurteilst, dann sind die folgenden drei Ebenen eines jeden Effekts von großer Bedeutung.

Abschließend stellt sich nun noch die Frage, wie groß die Stichprobe deiner Untersuchung denn idealerweise sein sollte.

Du hast deine Daten gesammelt und möchtest nun wissen, wie du deinen Datensatz in Excel aufbereitest, damit die spätere statistische Analyse deiner...

In diesem Artikel erkläre ich dir, wie du die Effekte einer ANOVA interpretierst und welche Arten von ANOVAs es gibt. Die ANOVA ist eines der am...

In diesem Artikel erkläre ich dir die 9 Schritte, die du durchlaufen musst, um eine ANOVA für Gruppenvergleiche korrekt zu berechnen und zu...

In diesem Artikel gibt R-Fachmann Simon Wilms eine Einführung in R für Ärzte und zeigt, wie der Einstieg in das Statistiktool einfach und effizient...

Wer sucht sie nicht – die ewige Liebe. Egal, welcher Altersgruppe, Herkunft oder Bildungsschicht wir angehören, jeder Mensch sehnt sich nach...

Fast jeder forschende Arzt kennt das Dilemma: Eine neue, schonende Therapieform soll mit der konservativen Standardtherapie verglichen...

Melde dich für meinen Newsletter an und erhalte sofort das PDF!

Melde dich für meinen Newsletter an und erhalte sofort das PDF!

Melde dich für meinen Newsletter an und erhalte sofort das PDF!

Melde dich für meinen Newsletter an und erhalte sofort die Excel-Vorlage!